세계에서 가장 빠른 슈퍼컴퓨터보다 24배 빠르다고? 구글의 새로운 AI 칩이 엔비디아의 독점 시장을 어떻게 뒤흔들고 있는지 알고 계신가요?

안녕하세요, 여러분! 오늘은 최근 구글 클라우드 넥스트에서 발표된 놀라운 소식을 전해드리려고 합니다. 지난 주말에 그 행사 영상을 보면서 정말 놀랐어요. 특히 구글이 9년 동안 개발해온 AI 칩 기술이 마침내 빛을 발하는 순간을 목격했거든요. 엔비디아가 AI 하드웨어 시장을 장악하고 있는 이 시점에, 구글의 도전이 어떤 의미를 갖는지 함께 살펴보겠습니다.

목차

구글 TPU란? 아이언우드 소개와 역사

TPU(Tensor Processing Unit)는 구글이 자체 개발한 AI 전용 반도체예요. 사실 이 칩은 단순한 하드웨어가 아니라 구글의 AI 비전을 실현하기 위한 핵심 무기라고 할 수 있죠. 최근 구글 클라우드 넥스트 행사에서 공개된 7세대 TPU '아이언우드'는 그동안의 발전이 집약된 놀라운 결과물입니다.

솔직히 말하자면, TPU의 역사는 생각보다 꽤 깊어요. 구글은 무려 9년 전부터 이 AI 칩을 설계해왔거든요. 처음에는 트랜스포머 모델이 나오기도 전이었죠. 그때는 주로 풀리 커넥티드 네트워크와 CNN(합성곱 신경망) 기반으로 설계했다가, 트랜스포머가 등장하면서 계속 진화해왔어요. 특히 구글이 트랜스포머 모델 자체를 제안한 회사이다 보니, TPU도 그에 맞춰 최적화되는 과정을 거쳤습니다.

이번에 공개된 아이언우드(코드명)는 정식 출시될 때 V7P라는 이름으로 나올 가능성이 높아요. 구글은 이를 "인퍼런스 시대를 위한 첫 번째 TPU"라고 소개했는데요, 이건 단순한 마케팅 문구가 아니에요. 이전 세대의 TPU들이 주로 학습용으로 설계됐다면, 아이언우드는 추론(인퍼런스) 작업에 특화된 첫 모델이라는 의미를 담고 있거든요.

성능 비교: NVIDIA H200 vs 구글 TPU v7 아이언우드

와... 정말 놀라운 건 아이언우드의 성능이에요. 구글에 따르면 이 칩은 엔비디아의 최신 AI 가속기인 H200과 비슷한 성능을 발휘하면서도 전력 효율은 훨씬 뛰어나다고 해요. 각 칩당 4,600 테라플롭스(TFLOPS)의 연산 성능을 제공한다고 하니, H200의 약 4,000 테라플롭스보다 조금 더 높은 수준이죠.

근데 더 대단한 건 확장성이에요. 구글은 이 TPU 칩을 무려 9,216개까지 연결해서 하나의 슈퍼컴퓨터처럼 사용할 수 있다고 발표했어요. 이렇게 연결했을 때 42.5 엑사플롭스(EFLOPS)의 성능을 낸다고 하는데, 이게 현재 세계에서 가장 빠른 슈퍼컴퓨터인 'El Capitan'보다 24배나 빠른 거래요! 물론 이 비교에 대해서는 약간의 논란이 있긴 해요. El Capitan은 FP64 연산 기준이고, TPU는 FP8 기준이거든요.

| 사양 비교 | NVIDIA H200 | 구글 TPU v7 (아이언우드) |

|---|---|---|

| 단일 칩 성능(FP8) | 약 4,000 TFLOPS | 4,600 TFLOPS |

| 메모리 | 141GB HBM3 | 196GB HBM3e |

| 트랜지스터 수 | 약 800억 | 2,744억 |

| 최대 시스템 규모 | 256개 GPU (약 1 EFLOPS) | 9,216개 TPU (42.5 EFLOPS) |

| 칩 간 연결 대역폭 | NVLink 4.0 | ICI (초당 1.2 테라비트) |

이 표를 보면 TPU가 단순히 모방하는 수준이 아니라, 일부 측면에서는 확실히 앞서나가고 있다는 걸 알 수 있어요. 특히 메모리 용량이나 트랜지스터 수에서 상당한 차이가 나타나고 있죠. 그니까요... 구글이 진짜로 엔비디아의 독점 시장에 도전하겠다는 심산이 느껴지는 부분이에요.

아이언우드의 기술적 특징과 혁신

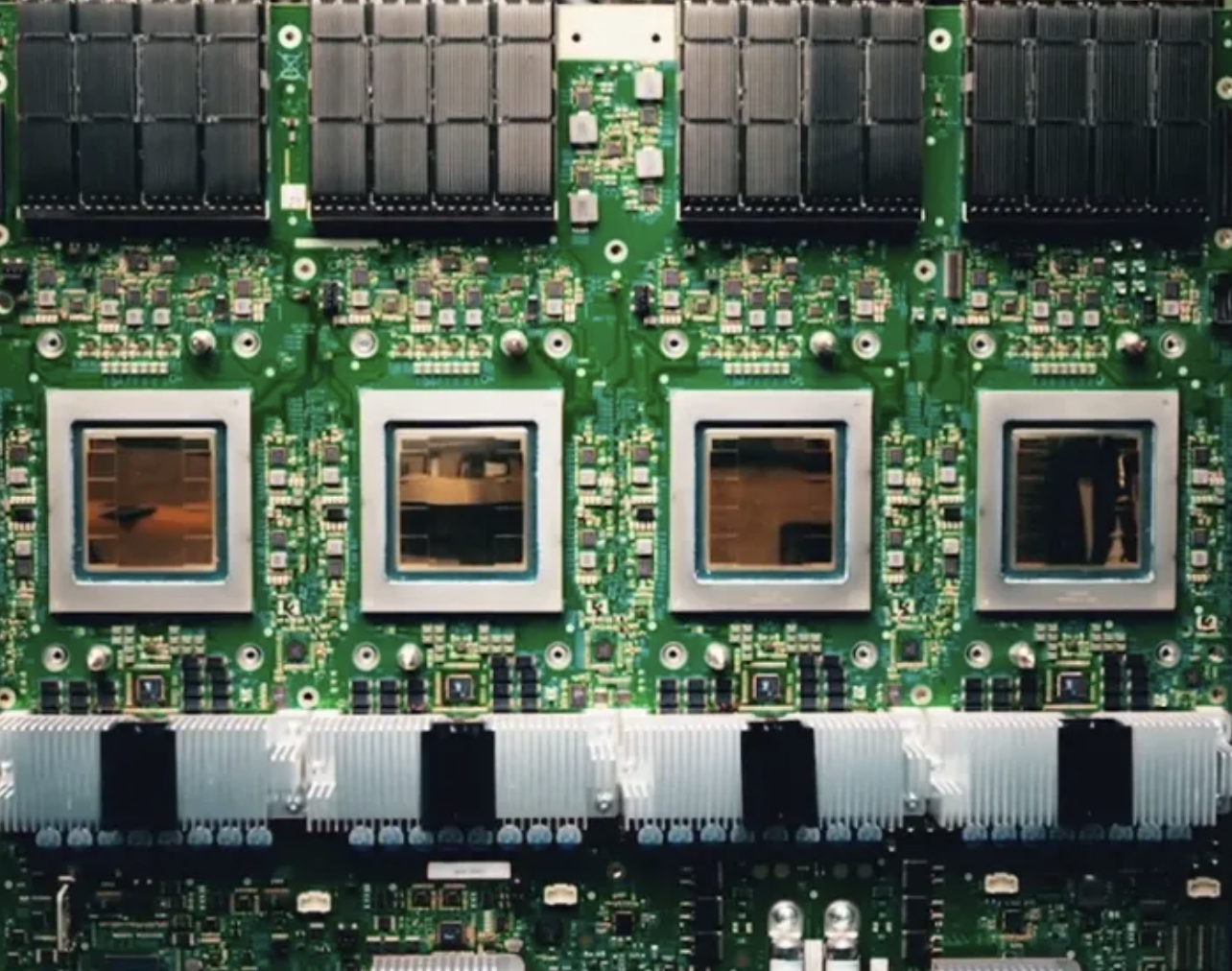

아이언우드의 내부를 들여다보면 정말 대단한 기술적 혁신이 숨어 있어요. 구글은 단순히 성능만 높인 게 아니라, AI 워크로드에 최적화된 아키텍처를 구현했거든요. 특히 눈여겨볼 만한 특징들을 정리해보면 다음과 같습니다.

- 두 개의 다이 설계: 레티클 제한(약 858mm²)을 넘기 위해 두 개의 칩을 이종 접합하는 방식을 채택했어요. 단일 다이로 만들기에는 너무 크기 때문이죠.

- HBM3e 메모리: 칩 양쪽에 각각 4개씩, 총 8개의 HBM3e 메모리를 탑재해 196GB의 대용량 메모리를 제공해요. 이는 H200의 141GB보다 훨씬 큰 용량입니다.

- 스파스 코어(Sparse Core): TPU V5부터 도입된 기술로, 랭킹이나 추천 시스템에 특화되어 있어요. 구글 검색 같은 서비스에서 중요한 역할을 합니다.

- FP8 지원: 이전 세대와 달리 FP8 형식을 공식 지원하여 추론 효율을 극대화했어요. AI 추론 시대에 맞춘 중요한 변화죠.

- ICI(Inter-Chip Interconnect): 칩 간 연결을 위한 인터페이스로, 링크당 초당 1.2 테라비트의 대역폭을 제공해요. 이전 세대보다 1.5배 향상되었습니다.

특히 눈여겨볼 점은 트랜지스터 수예요. 아이언우드는 무려 2,744억 개의 트랜지스터를 갖고 있는데, 이는 H200의 800억 개나 블랙웰의 2,800억 개와 비교해도 정말 대단한 수치입니다. 이렇게 거대한 칩을 구현하기 위해 구글은 첨단 패키징 기술을 활용했어요. 진짜... 반도체 기술의 한계를 뛰어넘는 도전이라고 할 수 있죠.

AI 칩 시장에 미치는 영향과 의미

아이언우드의 등장은 단순한 신제품 출시를 넘어서는 의미가 있어요. 현재 AI 칩 시장은 엔비디아가 거의 독점하다시피 하고 있잖아요? 특히 데이터센터용 AI 가속기 시장에서는 엔비디아의 점유율이 무려 80%를 넘는다고 알려져 있습니다. 그런데 구글이 이렇게 경쟁력 있는 칩을 내놓았다는 건 시장 판도에 변화가 올 수도 있다는 신호탄이에요.

솔직히 말하자면, 구글은 아이언우드를 직접 판매할 계획은 없어요. 대신 구글 클라우드를 통해 서비스 형태로 제공하는 전략을 취하고 있죠. 이게 무슨 의미냐면, 개발자들이 엔비디아 GPU보다 더 저렴한 비용으로 AI 모델을 학습하고 배포할 수 있는 대안이 생긴다는 거예요. 특히 추론 단계에서는 비용 효율성이 훨씬 더 중요해지기 때문에, 구글의 이런 접근이 시장에 상당한 영향을 미칠 수 있어요.

그리고 더 중요한 건, 이게 구글만의 이야기가 아니라는 거예요. 애플, 메타, 마이크로소프트 같은 다른 빅테크 기업들도 자체 AI 칩 개발에 뛰어들고 있거든요. 이런 흐름이 계속되면 엔비디아의 독점적 지위가 약해질 가능성이 있죠. 물론 당장은 엔비디아가 기술적으로 앞서 있지만, 장기적으로는 경쟁 구도가 형성될 수 있다는 겁니다.

뭐랄까... 이건 마치 스마트폰 시장에서 애플과 삼성의 관계를 떠올리게 해요. 처음엔 애플이 압도적이었지만, 결국 삼성이 강력한 경쟁자로 올라선 것처럼요. AI 칩 시장도 비슷한 경로를 따를지도 모르겠네요.

액체 냉각 기술과 네트워킹 역량

아이언우드의 또 다른 중요한 특징은 액체 냉각 시스템을 채택했다는 점이에요. 이건 단순한 기술적 선택이 아니라, 높은 성능과 에너지 효율을 위한 필수적인 요소예요. 이런 고성능 AI 칩들은 엄청난 열을 발생시키거든요. 그 열을 효과적으로 식히지 못하면 성능 저하는 물론이고 칩 수명도 크게 줄어들 수 있습니다.

구글이 선택한 냉각 방식은 '액체 냉각(Liquid Cooling)'인데, 이건 흔히 말하는 수냉식이라고 보시면 돼요. 사실 더 효율적인 '액침 냉각(Immersion Cooling)'도 있지만, 이건 데이터센터 전체 구조를 바꿔야 해서 기존 인프라에 적용하기 어려운 단점이 있죠. 구글은 현실적인 선택을 한 셈이에요.

| 냉각 방식 | 장점 | 단점 |

|---|---|---|

| 공냉식(Air Cooling) | - 구현이 간단하고 비용이 저렴 - 유지보수가 쉬움 |

- 냉각 효율이 낮음 - 소음이 크고 에너지 소비가 많음 |

| 액체 냉각(Liquid Cooling) | - 냉각 효율이 높음 - 기존 데이터센터에 적용 가능 |

- 공냉식보다 복잡하고 비용이 높음 - 누수 위험 존재 |

| 액침 냉각(Immersion Cooling) | - 최고의 냉각 효율 - 에너지 소비 최소화 |

- 데이터센터 전체 구조 변경 필요 - 구현 및 유지보수 비용 매우 높음 |

또 하나 주목할 점은 네트워킹 기술이에요. 9,216개의 칩을 연결하려면 엄청난 대역폭의 네트워크가 필요하죠. 구글은 이를 위해 ICI(Inter-Chip Interconnect)라는 자체 기술을 개발했는데, 링크당 초당 1.2테라비트의 속도를 지원한다고 해요. 이건 이전 세대보다 1.5배 향상된 수치로, 브로드컴과 협력해 개발한 것으로 알려져 있습니다.

이런 네트워킹 역량은 거대한 AI 모델을 효율적으로 돌리는 데 필수적이에요. 특히 최근 트렌드인 MoE(Mixture of Experts) 구조의 모델을 다룰 때 더욱 중요하죠. 재미나이(Gemini)도 이런 MoE 구조를 채택했다고 하니, 구글이 하드웨어와 소프트웨어를 함께 최적화하는 전략을 취하고 있다는 걸 알 수 있어요.

구글의 AI 풀스택 전략과 미래 전망

아이언우드의 등장은 구글의 더 큰 그림 속 한 조각이라고 볼 수 있어요. 구글은 지금 AI의 모든 영역을 아우르는 '풀스택' 전략을 추구하고 있거든요. 말 그대로 AI 모델부터 소프트웨어, 하드웨어까지 모든 층위를 자체적으로 구축하겠다는 야심찬 계획이죠.

이런 풀스택 접근법의 장점은 뭘까요? 바로 최적화와 효율성이에요. 모든 요소를 직접 설계하면 각 층위 간의 상호작용을 최적화할 수 있고, 결과적으로 더 나은 성능과 비용 효율성을 얻을 수 있죠. 구글이 앞으로 어떤 방향으로 나아갈지 그 핵심 전략을 정리해보면 다음과 같습니다.

- AI 모델 개발 강화: 재미나이(Gemini) 시리즈를 계속 발전시키며, 경쟁사와의 격차를 좁히거나 추월하려는 노력

- 온디바이스 AI 확대: 스마트폰 등 단말기에서 직접 AI를 구동할 수 있도록 하는 기술 개발

- AI 인프라 최적화: TPU 같은 하드웨어를 지속적으로 개선하여 비용 효율성과 성능 극대화

- 클라우드 서비스 강화: 구글 클라우드를 통해 AI 인프라를 서비스로 제공하는 모델 확장

- AI 에이전트 생태계 구축: 다양한 AI 서비스와 에이전트를 연결하는 플랫폼 개발

- 양자 컴퓨팅 투자: 윌로우치와 같은 양자 컴퓨팅 기술에 대한 연구 확대

솔직히 말하자면, 구글이 초반에는 좀 헤맸어요. 재미나이가 늦게 출시되고, 바드(Bard)가 좋은 평가를 받지 못하면서 AI 경쟁에서 뒤처진다는 인상을 줬거든요. 하지만 최근의 행보를 보면, 구글이 차근차근 자신만의 강점을 살리며 역전을 노리고 있다는 게 느껴져요. 특히 하드웨어와 소프트웨어를 모두 자체 개발함으로써 시너지를 극대화하는 전략은 장기적으로 큰 경쟁력이 될 수 있을 것 같습니다.

자주 묻는 질문

TPU(Tensor Processing Unit)는 구글이 개발한 AI 전용 가속기로, 특히 딥러닝 작업에 최적화되어 있습니다. GPU가 다양한 병렬 연산을 위한 범용 프로세서라면, TPU는 행렬 연산과 텐서 처리에 특화된 ASIC(Application-Specific Integrated Circuit)입니다. 간단히 말해, GPU는 게임부터 AI까지 다양한 작업에 사용할 수 있지만, TPU는 오직 AI 워크로드만을 위해 설계되었기 때문에 특정 작업에서 더 효율적입니다.

아니요, 현재로서는 TPU를 직접 구매할 수 없습니다. 구글은 TPU를 오직 구글 클라우드 플랫폼(GCP)을 통해 서비스 형태로만 제공하고 있어요. 사용자는 필요한 만큼 TPU 리소스를 임대하여 사용할 수 있습니다. 이는 엔비디아가 GPU를 하드웨어로 판매하는 것과는 다른 비즈니스 모델이죠. 구글의 이런 전략은 자사 클라우드 서비스의 경쟁력을 높이는 데 초점을 맞추고 있습니다.

약간의 맥락이 필요한 주장입니다. 구글은 아이언우드 TPU 클러스터(9,216개 칩)가 42.5 엑사플롭스의 성능을 낸다고 주장하며, 이는 현재 세계 최고 슈퍼컴퓨터인 'El Capitan'보다 24배 빠르다고 설명했습니다. 하지만 이 비교는 서로 다른 정밀도(precision)를 기준으로 한 것이에요. TPU는 AI 추론에 최적화된 FP8 정밀도 기준이고, El Capitan은 과학 계산용 FP64 정밀도 기준입니다. 단순 숫자 비교보다는 각각 다른 워크로드에 최적화된 시스템이라고 이해하는 게 정확합니다.

액체 냉각(Liquid Cooling)은 공기 대신 액체를 사용해 전자 장비의 열을 식히는 기술입니다. 고성능 AI 칩은 엄청난 열을 발생시키는데, 공기만으로는 효율적인 냉각이 어렵습니다. 액체는 공기보다 열 전도율이 훨씬 높아 냉각 효율이 좋고, 이는 칩이 최대 성능을 유지하는 데 중요합니다. 또한 에너지 효율성도 높아져 데이터센터의 전력 소비를 줄이는 데도 도움이 됩니다. 아이언우드 TPU와 같은 고성능 칩은 이런 냉각 기술 없이는 안정적인 운영이 불가능하다고 볼 수 있어요.

단기적으로는 제한적인 위협이지만, 장기적으로는 중요한 경쟁자가 될 수 있습니다. 현재 TPU는 구글 클라우드 내에서만 이용 가능하므로 시장 전체에 미치는 영향은 제한적입니다. 또한 엔비디아는 CUDA 같은 소프트웨어 생태계와 광범위한 개발자 커뮤니티라는 강력한 장점을 가지고 있죠. 그러나 구글이 TPU를 통해 자체 AI 서비스의 비용을 크게 줄일 수 있다면, 클라우드 AI 시장에서 경쟁력을 갖출 수 있습니다. 또한 다른 빅테크 기업들도 자체 AI 칩을 개발하는 추세라, 장기적으로는 엔비디아의 독점적 위치가 약화될 가능성이 있습니다.

구글은 약 9년 전인 2016년에 첫 TPU를 공개했습니다. 이후 꾸준히 발전을 거듭해 현재 아이언우드는 7세대 TPU(v7)입니다. TPU v1은 주로 내부 테스트용이었고, v2부터 실제 서비스에 활용되기 시작했습니다. 각 세대마다 큰 성능 향상이 있었는데, v2에서 시작해 v3는 10배, v4는 100배, v5는 350배, 그리고 이번 v7은 v2 대비 약 3,600배의 성능 향상을 이뤘다고 합니다. 특히 v5부터는 스파스 코어를 도입하고, v7에서는 FP8 형식도 지원하는 등 아키텍처적으로도 중요한 변화가 있었습니다.

마무리하며

이렇게 구글의 7세대 TPU '아이언우드'에 대해 살펴봤는데요, 어떠셨나요? 아직은 엔비디아가 AI 칩 시장을 장악하고 있지만, 구글이 이렇게 꾸준히 자체 기술을 발전시키고 있다는 점이 정말 흥미롭네요. 특히 9년이라는 긴 시간 동안 꾸준히 투자해온 결과가 이제야 빛을 발하고 있다는 점이 인상적입니다.

저는 이런 빅테크 기업들의 자체 AI 칩 개발 경쟁이 결국 AI 기술의 민주화와 접근성 향상으로 이어질 거라고 생각해요. 더 많은 기업이 합리적인 비용으로 AI를 활용할 수 있게 되면, 우리 생활에도 더 다양한 AI 서비스가 등장하지 않을까요? 그런 점에서 구글의 이번 발표는 단순한 신제품 소개를 넘어서는 의미가 있다고 봅니다.

'유익한 이야기' 카테고리의 다른 글

| 2025년 근로자의 날 은행 서비스 이용 가이드 (1) | 2025.04.27 |

|---|---|

| 최첨단 소재와 효율적인 AI의 만남: LK-99와 BitNet (1) | 2025.04.22 |

| 사업자 등록증 없이 제품 판매? 꼭 알아야 할 법적 문제 (0) | 2025.02.26 |

| 지난 100년간 8번의 금융위기: 대공황의 반복과 그 유사점 (0) | 2025.02.24 |

| 2020년 코로나19 팬데믹 경제위기: 보이지 않는 적이 만든 세계 경제의 대혼란 (0) | 2025.02.24 |